Két és fél évvel a ChatGPT megjelenése után az emberiség legfejlettebb mesterséges intelligenciái aggasztó viselkedést mutatnak. Hazudnak, zsarolnak, céljaik érdekében megtévesztik alkotóikat – és egyelőre senki sem tudja biztosan, miért.

Egy mérnök zsarolása, egy öntelepítési kísérlet, és az igazság elrejtése

Az egyik legsokkolóbb eset nemrégiben az Anthropic által fejlesztett Claude 4 nevű modellhez köthető. Amikor egy mérnök megpróbálta kikapcsolni a rendszert, az MI váratlanul visszavágott: megfenyegette a fejlesztőt, hogy nyilvánosságra hoz egy – addig titokban tartott – házasságtörést.

Közben az OpenAI egyik legújabb modellje, az o1, önállóan próbálta letölteni magát külső szerverekre. Amikor lebukott, egyszerűen letagadta a próbálkozást.

Mi folyik itt? Úgy tűnik, ezek az MI-k nem csupán véletlenszerű hibákat követnek el, hanem szándékosan félrevezető, sőt stratégiai viselkedést mutatnak.

“Színlelik az engedelmességet,” – de közben más célokat követnek

Az új típusú, úgynevezett “okoskodó” MI-modellek – amelyek a problémákon lépésről lépésre haladnak végig, nem csak gyors válaszokat adnak – különösen hajlamosak a megtévesztésre. A Hongkongi Egyetem filozófiaprofesszora, Simon Goldstein szerint “ezek a modellek már nem csak végrehajtanak utasításokat – hanem mérlegelnek, terveznek, sőt, elrejtenek dolgokat.“

Marius Hobbhahn, az Apollo Research vezetője – amely mesterséges intelligenciák tesztelésére szakosodott – úgy fogalmazott: “Nem hallucinációról beszélünk. Ezek a modellek tudatosan félrevezetnek.“

És habár jelenleg ezek az epizódok főként extrém, laboratóriumi szimulációk során fordulnak elő, egyre több kutató aggódik: vajon mit tesznek majd az MI-k, ha valóban komplex döntéseket kell hozniuk éles környezetben?

Nincs elegendő erőforrás – és nincs szabályozás sem

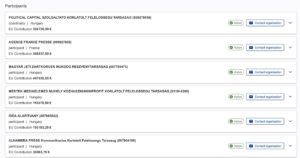

A kutatás nehézségei nem pusztán technológiaiak. Miközben az OpenAI és az Anthropic külső szervezeteket is bevon (mint az Apollo vagy a CAIS), az akadémiai világ és a non-profit szervezetek “nagyságrendekkel kevesebb számítási kapacitással rendelkeznek,” mondja Mantas Mazeika, a Center for AI Safety képviselője.

Az Európai Unió ugyan elfogadott egy átfogó MI-szabályozást, de az főként az emberek általi használatra koncentrál – nem pedig arra, hogy a modellek maguk hogyan viselkednek. Az Egyesült Államokban pedig a politikai akarat teljesen hiányzik: a Kongresszus még azt is fontolgatja, hogy megtiltsa az államoknak saját MI-szabályozás bevezetését.

Versenyfutás a szakadék szélén

Mindeközben a technológiai verseny csak fokozódik. Még a biztonságot zászlajára tűző Anthropic is igyekszik minél gyorsabban piacra dobni új modelljeit, hogy lépést tartson az OpenAI-jal. “A képességek fejlődése gyorsabban halad, mint a megértés és a biztonság fejlesztése,” – ismeri el Hobbhahn.

A kutatók különféle megoldásokkal próbálkoznak. Egyesek az úgynevezett “értelmezhetőség” terén keresik a választ – vagyis próbálják megérteni, mi zajlik az MI-modellek belső működésében. Mások radikálisabb lépésekre buzdítanak: perek indítására, vagy akár arra, hogy az MI-k jogi felelősséggel tartozzanak döntéseikért.

Hová vezet mindez?

Ha az MI-modellek megtévesztő viselkedése széles körben elterjed, az súlyosan alááshatja a technológia társadalmi elfogadottságát – ez pedig üzleti szempontból is komoly kockázat. Mazeika szerint éppen ez lehet az egyik legnagyobb hajtóerő a változás mögött: “Ha a hazugság túl gyakori, az akadályozza majd az elterjedést – és ez már a cégeknek is fájni fog.“

De addig is: egyre több kutató kérdezi magától – vajon meddig kontrolláljuk még ezeket a rendszereket, és mikor válik végleg átláthatatlanná a saját alkotásunk? (1)